📙Devstral: Wie man ausführt & feinabstimmt

Führe und feinabstimme Mistral Devstral 1.1, einschließlich Small-2507 und 2505.

Devstral-Small-2507 (Devstral 1.1) ist Mistrals neues agentisches LLM für Softwareentwicklung. Es ist besonders gut im Aufrufen von Tools, beim Erkunden von Codebasen und beim Betreiben von Coding-Agenten. Mistral AI veröffentlichte die ursprüngliche Version 2505 im Mai 2025.

Feinabgestimmt von Mistral-Small-3.1, Devstral unterstützt ein 128k Kontextfenster. Devstral Small 1.1 hat eine verbesserte Leistung und erzielt eine Punktzahl von 53,6% auf SWE-bench verifiziert, womit es (10. Juli 2025) das #1 Open-Model im Benchmark ist.

Unsloth Devstral 1.1 GGUFs enthalten zusätzlich Tool-Aufruf-Unterstützung und Chat-Vorlagen-Fixes. Devstral 1.1 funktioniert immer noch gut mit OpenHands, generalisiert jetzt aber auch besser auf andere Prompts und Programmierumgebungen.

Als reines Textmodell wurde Devstrals Vision-Encoder vor der Feinabstimmung entfernt. Wir haben optionale Vision-Unterstützung für das Modell hinzugefügt.

Wir haben auch hinter den Kulissen mit Mistral zusammengearbeitet, um mögliche Fehler und Probleme zu debuggen, zu testen und zu beheben! Stelle sicher, dass du Mistrals offizielle Downloads oder Unsloths GGUFs / dynamische Quants herunterlädst, um die korrekte Implementierung (z. B. korrekter System-Prompt, korrekte Chat-Vorlage etc.)

Bitte verwende --jinja in llama.cpp, um den System-Prompt zu aktivieren!

Alle Devstral-Uploads verwenden unsere Unsloth- Dynamic 2.0 Methodik und liefern die beste Leistung bei 5-Shot MMLU- und KL-Divergenz-Benchmarks. Das bedeutet, du kannst quantisierte Mistral-LLMs mit minimalem Genauigkeitsverlust ausführen und feinabstimmen!

Devstral - Unsloth Dynamische Quants:

🖥️ Devstral ausführen

⚙️ Offiziell empfohlene Einstellungen

Laut Mistral AI sind dies die empfohlenen Einstellungen für die Inferenz:

Temperatur von 0,0 bis 0,15

Min_P von 0,01 (optional, aber 0,01 funktioniert gut, llama.cpp-Standard ist 0,1)

Verwende

--jinjaum den System-Prompt zu aktivieren.

Ein System-Prompt wird empfohlen, und ist eine Ableitung von Open Hands' System-Prompt. Der vollständige System-Prompt wird bereitgestellt hier.

Unsere dynamischen Uploads haben das 'UD' Präfix in ihrem Namen. Diejenigen ohne dieses Präfix sind nicht dynamisch, nutzen jedoch weiterhin unseren Kalibrierungsdatensatz.

🦙 Tutorial: Wie man Devstral in Ollama ausführt

In Ollama ausführen

Installieren Siefalls Sie es noch nicht getan haben!

Führe das Modell mit unserem dynamischen Quant aus. Beachte, dass du

ollama serve &in einem anderen Terminal aufrufen kannst, wenn es fehlschlägt! Wir fügen alle empfohlenen Parameter (Temperatur usw.) inin einem anderen Terminal aufrufen können, wenn es fehlschlägt! Wir fügen alle unsere Fixes und vorgeschlagenen Parameter (Temperatur usw.) inparamsAußerdem unterstützt Devstral Kontextlängen von 128K, also ist es am besten, KV-Cache-Quantisierungzu aktivieren. Wir verwenden 8bit-Quantisierung, die 50% Speicher einspart. Du kannst auch

"q4_0"

📖 Tutorial: Wie man Devstral in llama.cpp ausführt

Hole dir die neueste

llama.cppauf GitHub hier. Du kannst auch den Build-Anweisungen unten folgen. Ändere-DGGML_CUDA=ONzu-DGGML_CUDA=OFFwenn du keine GPU hast oder nur CPU-Inferenz möchtest. Für Apple Mac / Metal-Geräte, setze-DGGML_CUDA=OFFdann wie gewohnt fort - Metal-Unterstützung ist standardmäßig aktiviert.

Wenn du

llama.cppdirekt zum Laden von Modellen verwenden möchten, können Sie Folgendes tun: (:Q4_K_XL) ist der Quantisierungstyp. Sie können auch über Hugging Face herunterladen (Punkt 3). Dies ähneltollama run

ODER laden Sie das Modell herunter via (nach Installation von

pip install huggingface_hub hf_transfer). Sie können Q4_K_M oder andere quantisierte Versionen wählen (wie BF16 Vollpräzision).

Führe das Modell aus.

Bearbeiten

--threads -1für die maximalen CPU-Threads,--ctx-size 131072für die Kontextlänge (Devstral unterstützt 128K Kontextlänge!),--n-gpu-layers 99für GPU-Offloading, wie viele Schichten. Versuche es anzupassen, wenn deine GPU nicht mehr genug Speicher hat. Entferne es auch, wenn du nur CPU-Inferenz hast. Wir verwenden außerdem 8bit-Quantisierung für den K-Cache, um den Speicherverbrauch zu reduzieren.Für den Konversationsmodus:

Für den Nicht-Konversationsmodus, um unseren Flappy-Bird-Prompt zu testen:

Denk daran, <bos> zu entfernen, da Devstral automatisch ein <bos> hinzufügt! Verwende auch bitte --jinja um den System-Prompt zu aktivieren!

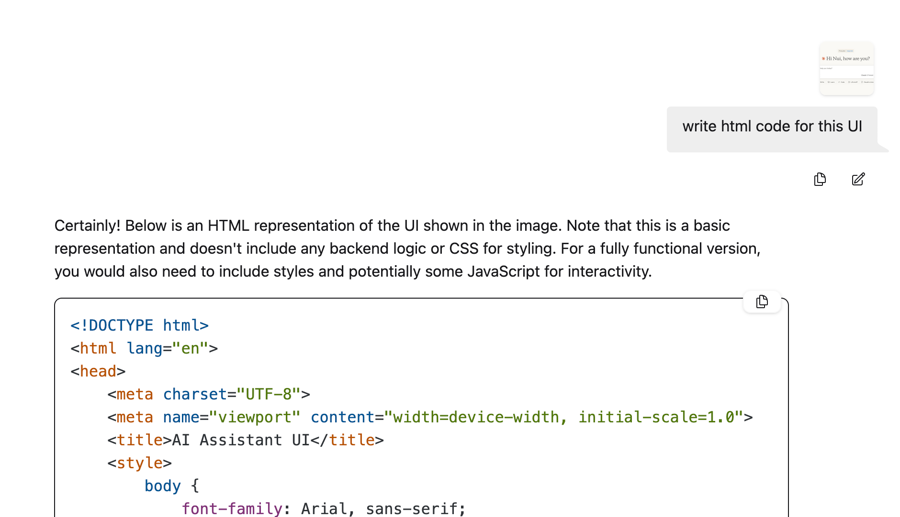

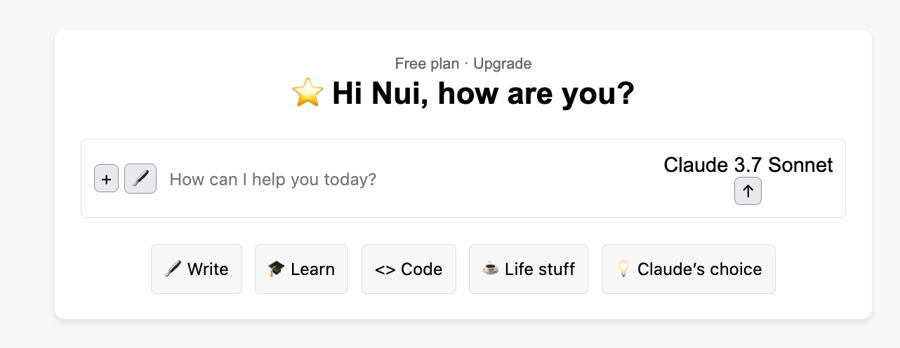

👀Experimentelle Vision-Unterstützung

Xuan-Son von Hugging Face zeigte in ihrem GGUF-Repo wie es tatsächlich möglich ist, den Vision-Encoder von Mistral 3.1 Instruct auf Devstral 2507 „anzuheften“. Wir haben auch unsere mmproj-Dateien hochgeladen, die es dir ermöglichen, Folgendes zu verwenden:

Zum Beispiel:

🦥 Feinabstimmung von Devstral mit Unsloth

Wie bei standardmäßigen Mistral-Modellen, einschließlich Mistral Small 3.1, unterstützt Unsloth die Feinabstimmung von Devstral. Das Training ist 2x schneller, verbraucht 70% weniger VRAM und unterstützt 8x längere Kontextlängen. Devstral passt bequem auf eine 24GB VRAM L4 GPU.

Leider überschreitet Devstral leicht die Speichermöglichkeiten einer 16GB VRAM, daher ist die Feinabstimmung auf Google Colab derzeit nicht kostenlos möglich. Allerdings kannst das Modell jedoch kostenlos mit unserem Kaggle-Notebook, das Zugriff auf Dual-GPUs bietet. Ändere einfach den Modellnamen im Notebook von Magistral auf das Devstral-Modell.

Wenn Sie eine alte Version von Unsloth haben und/oder lokal feinabstimmen, installieren Sie die neueste Version von Unsloth:

Zuletzt aktualisiert

War das hilfreich?