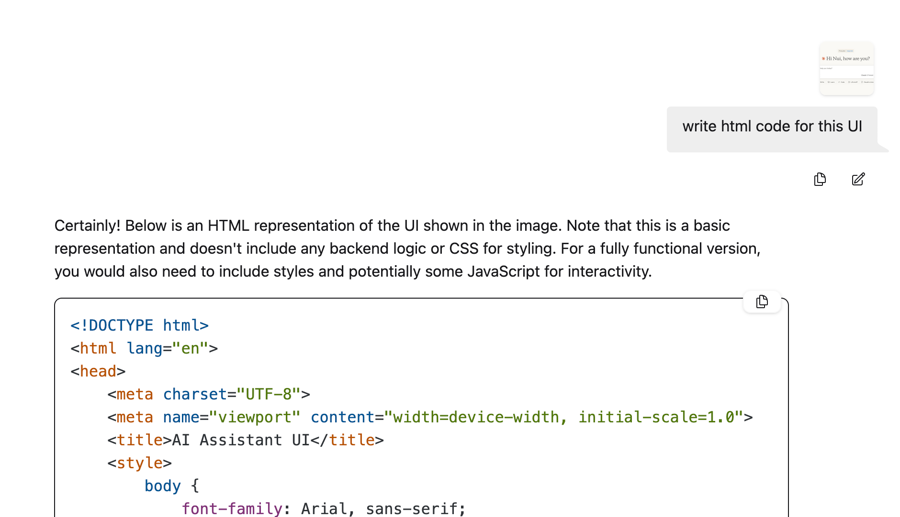

📙Devstral:如何运行与微调

运行并微调 Mistral Devstral 1.1,包括 Small-2507 与 2505。

Devstral-Small-2507 (Devstral 1.1)是 Mistral 的新一代具代理能力的软件工程大型模型。它擅长调用工具、探索代码库并为编码代理提供动力。Mistral AI 于 2025 年 5 月发布了最初的 2505 版本。

微调自 Mistral-Small-3.1,Devstral 支持 128k 上下文窗口。Devstral Small 1.1 性能有所提升,在 SWE-bench 验证上取得了 53.6% 的成绩,使其(截至 2025 年 7 月 10 日)成为该基准上的第 1 名开源模型。

Unsloth 的 Devstral 1.1 GGUF 包含额外的 工具调用支持 和 聊天模板修复。Devstral 1.1 仍然与 OpenHands 配合良好,但现在也更好地泛化到其他提示与编码环境。

作为纯文本模型,Devstral 的视觉编码器在微调前被移除。我们为模型添加了 可选的视觉支持 。

我们还与 Mistral 在幕后合作,帮助调试、测试并修正任何可能的错误和问题!请务必 下载 Mistral 的官方发行或 Unsloth 的 GGUF / 动态量化以获得 正确的实现 (即正确的系统提示、正确的聊天模板等)

请在 --jinja 的 llama.cpp 中使用以启用系统提示!

所有 Devstral 上传都使用我们的 Unsloth Dynamic 2.0 方法论,在 5-shot MMLU 和 KL 散度基准上提供最佳性能。这意味着,你可以以最小的精度损失运行并微调量化的 Mistral LLM!

Devstral - Unsloth 动态 量化:

🖥️ 运行 Devstral

⚙️ 官方推荐设置

根据 Mistral AI 的说法,以下是推理的推荐设置:

温度从 0.0 到 0.15

Min_P 为 0.01(可选,但 0.01 表现良好,llama.cpp 默认为 0.1)

使用

--jinja以启用系统提示。

建议使用系统提示,并且它是基于 Open Hands 的系统提示的衍生版本。完整的系统提示已提供 。更多信息请阅读.

我们的动态上传文件名中带有 'UD' 前缀。没有前缀的不是动态版本,但仍然使用我们的校准数据集。

🦙 教程:如何在 Ollama 中运行 Devstral

安装

ollama如果你还没有安装!

使用我们的动态量化运行该模型。注意如果失败你可以在另一个终端调用

ollama serve &!我们在params中!中包含了所有建议的参数(温度等)。另外 Devstral 支持 128K 上下文长度,最好启用 KV 缓存量化。我们使用 8bit 量化以节省 50% 的内存使用。你也可以尝试

"q4_0"

📖 教程:如何在 llama.cpp 中运行 Devstral

获取最新的

llama.cpp于 此处 GitHub。您也可以按下面的构建说明进行。若要更改-DGGML_CUDA=ON为-DGGML_CUDA=OFF若您没有 GPU 或仅想要 CPU 推理,请这样设置。

如果您想直接使用

llama.cpp来加载模型,你可以如下操作:(:Q4_K_XL)是量化类型。你也可以通过 Hugging Face 下载(见第 3 点)。这与ollama run

或 通过以下方式下载模型(在安装

pip install huggingface_hub hf_transfer后)。你可以选择 Q4_K_M,或其他量化版本(例如 BF16 全精度)。

运行该模型。

编辑

--threads -1用于最大 CPU 线程,--ctx-size 131072用于上下文长度(Devstral 支持 128K 上下文长度!),--n-gpu-layers 99用于在 GPU 上卸载多少层。若你的 GPU 内存不足可尝试调整。如果你仅使用 CPU 推理,也请移除该项。我们还对 K 缓存使用 8bit 量化以降低内存使用。用于对话模式:

用于非对话模式以测试我们的 Flappy Bird 提示:

记得移除 <bos> 因为 Devstral 会自动添加 <bos>!另外请使用 --jinja 来启用系统提示!

👀实验性视觉支持

Xuan-Son 在 Hugging Face 的 GGUF 仓库 中展示了如何实际上可以将 Mistral 3.1 Instruct 的视觉编码器“嫁接”到 Devstral 2507 上。我们也上传了 mmproj 文件,允许你使用以下内容:

例如:

🦥 使用 Unsloth 对 Devstral 进行微调

与包括 Mistral Small 3.1 在内的标准 Mistral 模型一样,Unsloth 支持对 Devstral 的微调。训练速度快 2 倍,使用 70% 更少的显存并支持 8 倍更长的上下文长度。Devstral 可以舒适地运行在 24GB 显存的 L4 GPU 上。

不幸的是,Devstral 略微超出 16GB 显存的内存限制,因此目前无法在 Google Colab 上免费微调。不过,你可以使用 可以 使用我们的免费 Kaggle 笔记本,它提供双卡 GPU 的访问。只需将笔记本中的 Magistral 模型名称更改为 Devstral 模型。

如果你有旧版本的 Unsloth 和/或在本地微调,请安装最新版本的 Unsloth:

最后更新于

这有帮助吗?